智慧家庭實驗室 林祐祺

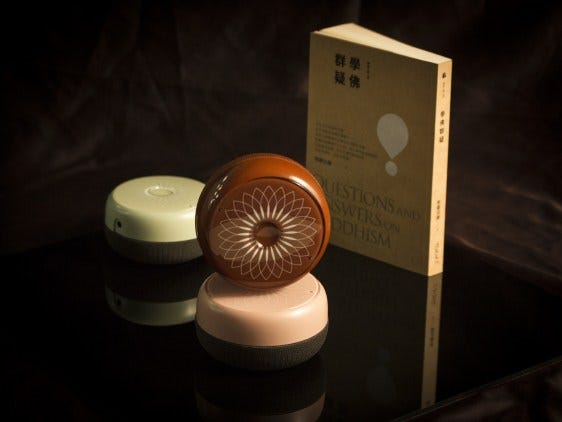

智慧音箱+智慧家庭 (https://medium.com/@deepak/telstra-googlehome-compatibility-2ea6a7ff9dca )

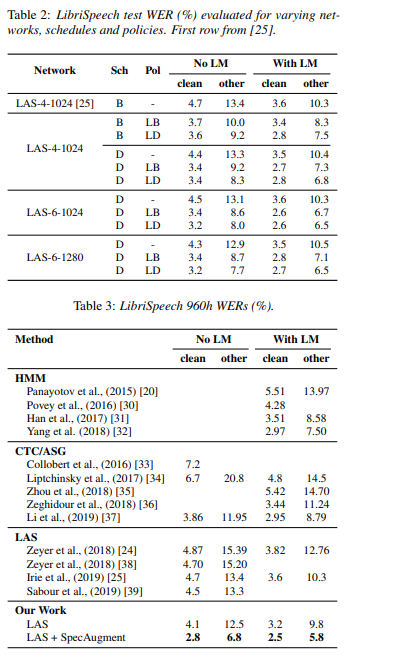

各位讀者大家好,之前連載完的「

智慧家庭深入探討 (一)~(八) 系列」,跟大家比較嚴肅的聊了智慧家庭產業面一些發展中的問題瓶頸與市場機會,而接下來開始連載的「智慧家庭ABC」,將與讀者聊聊智慧家庭服務與各類產品的使用情境與平易近人的生活應用,包括了消費端與商業端的應用。

首先,就是已經進入台灣市場兩年多了,但是終端銷量始終不慍不火的智慧音箱,最為一個通道型的產品(把其他產品跟服務帶進家門的通道),在台灣市場由於整個智慧生活大環境發展緩慢,導致在國外藉由智慧音箱帶動智慧家庭發展的狀況並沒有出現,但是情況會隨著科技進入生活逐漸改善,比如突然在今年爆發的美食外送服務,誰敢說一年後不會滿街都是講著中文的智慧音箱在各行各業做服務?

智慧家庭從1997年比爾蓋茲的第一個智慧豪宅開始,服務範疇從過去的家庭自動化系統開始,一直到現在包山包海的五大智慧家庭應用為止,包括了家庭安全 (Home Security)、智慧家電與能源管理 (HEMS)、健康照護 (Elderly Care)、生活服務 (食衣住行育樂)、最後是家庭娛樂包括數位影音等串流服務等等。一路以來都是不溫不火的發展,一直到智慧音箱的問世,才把智慧家庭又拱上風頭浪尖,成為未來最有可能改變人們日常生活的一種科技。

下圖是中國一家研究機構對「未來哪項技術最有可能改變人們的生活」進行了消費者市場調研,在全球七個國家(巴西、德、日、英、中、美、韓國)採取線上訪談、問卷等方式,對該7大市場的7000+消費者進行招募及採訪。其中,在中國市場75%的中國消費者認為“智慧家庭“技術「最有可能對未來的生活產生影響。

source: GfK 中国智能音箱市场分析

智慧家庭是人工智慧在家庭消費端最可能也最重要的落地場景。而智慧音箱又是智慧家庭在人工智慧現階段的最佳實現。

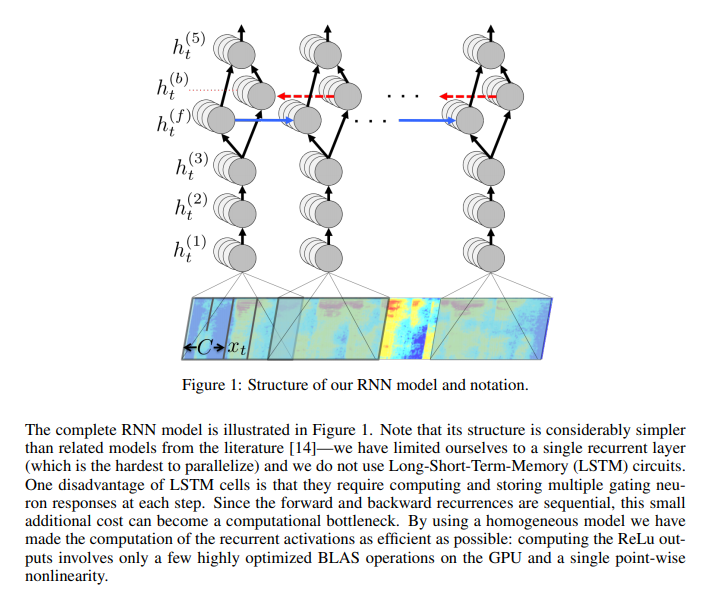

智慧家庭緣起於家庭系統的整合,比如整合了網路系統、家居照明控制、安全監控、對講、家庭劇院與多媒體、家庭環境控制、能源管理等,早期微軟也一直有讓 PC 成為智慧家庭中心的夢想,但一直到亞馬遜的第一台 Echo 智慧音箱發佈於 2014年11月 。

從那開始,定位在「能說話的 Wi-Fi 音箱」打敗了當時的王者 Sonos,定義了智慧音箱的 Category,亞馬遜就一直領導著智慧音箱產品的發展,也間接地重新定義了智慧家庭產業在消費者端的位置,很多家庭的智慧家庭系統是由智慧音箱入手的那一刻開始,陸續的添購了各式各樣智慧家庭產品與服務。

晚了將近兩年的時間,谷歌於2016年10月,推出了 Google Home 智慧音箱,不得不進入的原因,在於亞馬遜的 Echo 智慧音箱已經逐漸開始與手機搶食人類上網的時間與方式,聲控人機互動的易學性與方便性,讓手機大廠備感威脅。

在2019的出貨量已經逐漸追上亞馬遜的智慧音箱,主要有兩大原因,就是谷歌在人工智慧的領導地位,以及谷歌過去在全球在地化的優勢,都讓谷歌的智慧音箱快速在世界各地與電信商結合快速發展,另外谷歌原本在安卓體系的手機生態系夥伴,也會逐步地加入自帶谷歌語音助手的智慧音箱與智慧電視的生產製造販售,加速谷歌在全球智慧家庭市場的發展進程。

而在手機行業相當強勢的蘋果呢?其實蘋果早在2014年就發佈了 HomeKit 智慧家庭平台,2015年首批支持 HomeKit 平台的智慧家庭設備上市銷售,在2016年6月的蘋果開發者大會上,蘋果宣佈了與建商開始合作銷售 HomeKit 系統內置的新成屋,而在2018年2月時,蘋果的 HomePod 智慧音箱終於上市。與亞馬遜與谷歌在發展智慧家庭上採用開放平台的不同,蘋果嚴格的控制智慧家庭裝置申請加入 HomeKit 平台的流程,以及相當重視用戶體驗設計的一致性與端到端的安全性,因此在支持 HomeKit 平台的產品數量與異質性一直遠遠落後亞馬訓與谷歌,但是不可諱言,蘋果重視用戶體驗與安全性對於用戶而言是比較有使用保障的,智慧家庭碎片化與安全性一直是侷限產業發展的重要因素,蘋果一步一腳印的發展型態是否能在最後與快速發展的另外雙強抗衡呢?或許是有機會的。

另外在我們鄰近的亞洲國家,日本、韓國、中國也正快速的發展著,中國的百度、阿里巴巴、小米也是三強鼎立,百度甚至在 2019Q2 的全球出貨量超越了谷歌成為世界第二,而三強也佔據了中國智慧音箱市場接近 9 成的市佔率,也同時帶動了中國市場智慧家庭的蓬勃發展,而與台灣生活方式類似的韓國與日本,也正由電信商領頭快速地發展其智慧家庭生態產業,其發展方式可以做為台灣產業與電信商的借鏡。

https://www.sktsmarthome.com/

市場應用案例說明

在進入市場應用之前,先看看一個典型的泛用型音箱,其所串接的產品與服務有很多種類,比如智慧家庭類產品、智慧家電、電商、串流音樂與有聲書等數位內容、生活資訊、新聞、生活小工具、O2O 生活服務等等。

智慧音箱生態系 = 智慧家庭/家電 + 數位內容 + O2O服務 + 語音購物 + 語音廣告

由這張智慧音箱生態圈示意圖可以看得出來,智慧音箱必須串接硬體、內容、服務三種要素,才能讓使用者透過智慧音箱得到更多的加值服務,常見的如下:

硬體 (智慧家庭裝置、智慧家電、穿戴式裝置、醫療器材等)

智慧家庭裝置最常見的,就是攝影機與一些安全防盜裝置的搭配,比如攝影機搭配門磁,就可以抓拍小孩放學回家並通知父母親,或者透過智慧音箱呼叫兒童或者敬老房的即時影像,播放在電視之上(如下),又或者近年來開始流行的智慧門鎖,也是一個可以省去忘記帶鑰匙或者想要臨時幫親友開門的便利方式。

Swann Security Now Works with the Google Assistant

而老人家常常忘記關瓦斯爐、忘記帶鑰匙、晚上夜起等情境,也都是智慧裝置可以協助生活更順利的部分。而在家庭自動化的三大管理項目 — 燈控、電控、影音設備管理,相當可以讓生活更加的懶惰:p

在智慧家電方面,吸引人的情境一直無法串聯,家電廠推聯網化的動力往往只是販售更多的家電,並沒有如小米生態圈一樣有野心有策略地逐步吸引用戶持續購買,即使 TaiSEIA 協議已經通過 CNS 國家標準,但是並沒有大幅帶動智慧家電的銷量,缺乏使用場景的鴻溝還是頗為巨大。

台灣智慧能源產業協會 http://www.taiseia.org.tw/

而在健康照護方面,用戶對於在亞健康或者慢性病時期的「量測型儀器+雲數據」的銷售方式目前並沒有相當大的興趣,看來必較強的需求還是來自長照配套服務與在宅終老,但這方面各方都還在鴨子划水,出色的方案並不多見,但日後聲控的交互模式勢必是照顧幼兒與長輩的利器。

內容 (影視、音樂、有聲書、睡前故事、新聞、廣播、播客等)

目前除了線上音樂之外,似乎在其他內容比較難有營利模式,下圖是國外預載 Spotify 的智慧音箱,當真是 Spotify Everywhere~

但個人對於不論在帶螢幕或不帶螢幕的智慧音箱上,幼兒教育、互動式廣播劇、VTuber、老人家愛聽的唱歌與賣藥等內容還是寄與厚望。

https://spotify-everywhere.com/collections/smart-speakers

O2O生活服務 (食衣住行育樂的App轉語音控制服務)

相較於中國與北美這類大陸型市場,台灣人對於在線上叫服務的需求不高,在都市區便利商店林立,裡面可以解決吃喝問題、可以訂票繳費取貨、買一杯飲料可以坐一下午吹冷氣當K書中心,現在可能還會有健身房,智慧音箱要跟超商搶用戶服務渠道,難度很高。

熊貓外送排爆滷味攤 (https://udn.com/news/story/8864/3999464 )

但是有鑒於最近餐飲外送平台興起的驚人氣勢,讓我逐漸相信人類的懶惰終究還是會戰勝一切,智慧音箱所搭載的聲控呼叫生活服務勢必會越來越受歡迎。

語音購物的關鍵技術瓶頸有二,在於多輪對話/多種語境的對話決策還不到位,以及聲紋辨識技術還只能用在個人化服務,並無法如臉辯已經能用在門禁與付款上,雖然國內外電商應該都會在下半年推動語音購物的促銷活動,但對於語音購物進入主流應用都還有努力的空間。

但是,語音購物與廣告的龐大商機,終究是亞馬遜與谷歌拼戰語音助手跟智慧音箱的根本原因,而在台灣雖然發展較為緩慢,但是「OMO+語音購物+精準廣告+智慧家庭感測聯網平台」

感覺起來智慧家庭與智慧音箱的戰場,不是家大業大就沒有投入的空間?

其實不然,各式各樣的加值服務都是一個個的垂直市場,這些都是世界級大廠不會介入的利基市場。不論在方言的部分,比如閩南語、客家語的ASR/TTS,或者針對老人或者小孩應用場景的語庫建立,比如健康照護或者幼兒教育等等,都是台灣智慧音箱廠商可以著力的部分。

而在AI人工智慧語音的發展載具上,從手機一直到目前風行的智慧音箱,而接下來的桌上型、陪伴型、迎賓型的各類AI服務機器人,也勢必在幾年內會成為市場主流,最後則是進入人形機器人的時代。