What’s Going On With Facial Recognition? —— | Untangled

|

| 康橋科技 —— 白光攝影機專業廠商! |

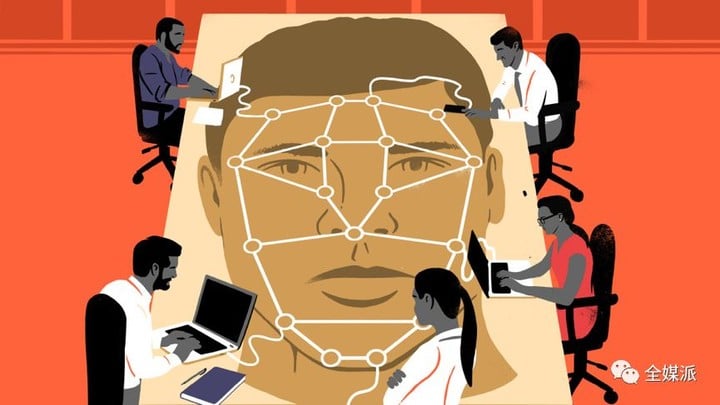

「刷臉」進門,「靠臉」吃飯…… 在人臉辨識技術日漸成熟的今天,這些曾經的想像已經無限接近於現實。根據對岸中國前瞻行業研究院的預測,未來五年中國人臉辨識整體市場將快速成長,實現多行業應用,預計到 2021 年中國人臉辨識市場規模將突破 50 億元。

▲在 2018 年北京安博會上,參觀者走過一個展示臉部辨識軟體的螢幕

但是,在人臉辨識一路狂奔的同時,技術開發所涉及的隱私問題日漸暴露,應用中的弊病也逐漸凸顯。

試想,在簡單「刷臉」就能完成一切的同時,你的五官數據將永遠成為網路數據集的一部分,甚至有可能被不同的機構調用。人臉辨識所帶來的並不只是便利、高效和未來感,在現階段,它應該更多地與倫理、審查、規範化相聯繫。本期全媒派(ID:quanmeipai)帶來獨家編譯,讓我們放下對這項技術的想像與憧憬,從最現實的角度對其進行探討和反思。

當研究數據被永久儲存,如何划定隱私邊界

當你走進一家坐著 20 個人的咖啡店,至少會有 22 個攝影機在你身邊:每個人的手機裡有一個,另一個通常高高懸掛在角落。你說的內容可能被偷聽或被發佈出去,你甚至可能出現在另一位顧客的自拍或視訊會話背景中。但即使最注重隱私的人也不會因此而拒絕進入咖啡店,因為人們都能接受進入公共場所固有的風險。

正是這種對隱私的「合理」期望,使那些需要在公共場合,採集人臉辨識研究對象的研究者心安理得。但是,當公共場合採集的資訊成為了永久且開放的數據集,如何划定「合理」的隱私邊界,就成為了一片學術倫理尚未完善的灰色地帶。

成為數據集的研究對象

杜克大學、史丹佛大學和科羅拉多州立大學多泉分校的學者們,都利用了校園監控作為捕捉研究對象的手段,但這一行為引起了強烈的反對。雖然人們對在咖啡店裡,被人偷聽有心理準備,但卻沒有想過會突然變成研究對象,更何況,被錄入的研究對象,將永遠成為數據集的一部分。

倫理委員會(IRB)批准了這三個,使用學生數據來改進機器學習算法的研究項目。杜克大學研究員 Carlo Tomasi 在《杜克大學紀事報》(Duke Chronicle)的一份聲明中表示,他「真誠地認為」自己遵循了委員會的指導方針。

為了開展研究,他和他的同事在公共區域的所有入口處張貼海報,告訴人們他們正在被記錄,如果他們想要刪除自己的數據,可以留下聯繫資訊。Tomasi 也告訴《紀事報》,沒有人主動來聯繫研究團隊刪除數據。

但 Tomasi 承認,他沒有通知 IRB 自己研究範圍的變化。一般來說,微小的變化是可以不用上報的,但是 Tomasi 獲得的批准是在室內錄製,並且只有提交請求才能訪問數據庫。但現實中,他在室外錄製,並且將數據庫向所有人開放。他向《紀事報》表示,「IRB 不應該受到指責,因為我沒有在關鍵時刻咨詢他們。我對我的錯誤承擔全部責任,我向所有被記錄的人和此舉對杜克大學造成的影響道歉」。

有限的監管和失控的後果

在科羅拉多州立大學多泉分校,首席研究員表示雖然他們透過學生數據來測試技術,但是團隊從未收集過具體到個人的識別資訊。在獨立聲明中,大學們都重申 IRB 批准了所有研究,並強調了其對學生隱私的承諾。

但問題在於,大學倫理委員會的監管範圍是有限的。他們主要關注研究是如何進行的,但對研究將會如何結束,後續會產生什麼影響卻並不關心。

正如蓋辛格的 IRB 領導委員會主席、生物倫理學家 Michelle Meyer 所解釋的那樣,IRB 主要關注的隱私問題,是在公共場所開展觀察研究時,研究對象是否被單獨辨識,以及對他們的辨識,是否會使他們面臨實質利益或生理上的傷害。

「從理論上講,如果你正在製造一枚核彈,其中涉及調查或採訪人類受試者,那麼 IRB 考慮的風險,將是直接參與該項目的人員面臨的風險,而不是核爆炸的潛在風險。」

值得注意的是,在資訊時代,大多數學術研究都依靠網路,而網路上的資訊將永遠存在。為其他研究人員開放數據集會增加伴生風險,但 IRB 在這一方面並沒有多少管轄權。因為從根本上說,數據共享與研究本身並不是一回事,因此它處在「一個奇怪的灰色監管地帶」,Meyer 解釋說。

如果 IRB 對研究可能導致的後果漠不關心,那麼其他不受 IRB 標準約束的研究人員,就可以下載數據集並按照他們的意願隨意使用。而被研究的對象卻對自己正在被研究這件事全然不知,這可能會導致各種消極的後果。

這些後果或許遠遠超出研究人員的想像。德國反監視專家 Adam Harvey 在全球範圍內發現了 100 多個引用杜克數據集的機器學習項目。他創建了一張地圖,用於追蹤這一數據集在全球的傳播情況,就像飛機的航線圖一樣,從杜克大學向各個方向延伸出長長的藍線,指向世界各地的大學、新創企業和研究機構,包括中國的商湯科技(SenseTime)和曠視科技(Megvii)。

每次有新項目訪問數據集時,損害可能導致的影響和範圍都會發生變化。數據的可移植性和網際網路的快速度結合在一起,大大擴展了一個研究項目的可能邊界,也把風險擴展到遠遠超出任何一所大學能承擔的範圍。

解決嘗試:建立學術審查系統

杜克大學最終決定刪除與該研究相關的數據集。史丹佛大學清除了研究人員基於舊金山咖啡館的顧客所創建的數據集。

科羅拉多大學博爾德分校資訊科學系助理教授 Casey Fiesler 撰寫了關於在研究中使用公共數據的倫理學。Fiesler 提出了一種用於審查數據集訪問的系統,與審查版權類似。她指出,系統中的使用條款主要關注請求者計劃如何使用該數據。

「為這些數據集設置守門人是一個好主意」,她說,「因為只要明確使用目的,請求者就能夠訪問數據集。」類似的規則在開源軟體,和 Creative Commons 的標準化版權許可協議上已有應用。

Creative Commons 是一種基於許可的系統,請求者只能將獲得的作品作為非商業用途,而一旦他們隱瞞或歪曲意圖,則需要承擔責任。這些標準可能與學術環境並不完全匹配,但至少在切斷後續傷害方面是有用的。「這並不是將規則繁瑣化,但它提出了一種方法,使得你無論決定要做什麼時,都把前後因果考慮進去」,Fiesler 說。

種族歧視&影響執法,應用中暴露的技術盲區

當人臉辨識技術走出實驗室,走進現實生活,它就被賦予了更多意義 —— 你的臉將不再只是一張具有生物屬性的臉了。在足球比賽中,你的臉是貨幣,用於在體育場購買食物。在商場,它是一個賬本,用於告訴銷售人員你過去的購買行為以及購物偏好。在抗議中,你的臉會反映出你過去被逮捕的歷史。即使在太平間,臉也能幫助官方機構辨識遺體。

隨著人臉承載的意義不斷加強,技術錯誤導致的後果嚴重性也隨之增強。在現階段的應用中,人臉辨識技術的一些弊端已經暴露。

辨識準確度存在差異,加劇種族歧視

2016 年麻省理工學院的研究員 Joy Buolamwini 研究表明,人臉辨識技術的準確性在膚色較淺的男性中表現優於膚色較深的男性,而對於膚色較深的女性則表現最差。

美國公民聯合會(ACLU)也發現了類似的問題。當 ACLU 將國會議員與犯罪數據庫進行匹配時,亞馬遜的 Rekognition 軟件對黑人議員的錯誤辨識比白人議員多得多,儘管黑人議員在總體數量中佔比更小。其中包括眾議院議長 Elijah Cummings,一名巴爾的摩人。

對不同膚色人種間辨識的準確度差異,可能加劇種族歧視的指責,微軟和亞馬遜都聲稱,自麻省理工學院和 ACLU 的報告發佈以來,他們的公司已經優化了技術,對辨識不同種族在準確性方面的差異。但是,更準確地辨識有色面孔,只是技術需要改進的一部分,因為即使完全準確的技術,仍然可以用來支持對有色人種有害的執法措施。

對技術本身的改進和完善,並不是最重要的議題,如何使用這項技術才更應該被關注。微軟和亞馬遜提出的解決方案,是在技術應用後對臉部辨識存在問題進行糾正,但這只是亡羊補牢。

人臉辨識執法,可行性存疑

5 月初,《華盛頓郵報》報導稱,警方正在使用臉部辨識軟體抓捕疑犯。一名目擊者向警方描述了嫌疑人的外貌,警察據此畫出草圖上傳到亞馬遜的 Rekognition,並最終逮捕了某人。這一事件震驚了國會聽證會上的專家 —— 提交給數據庫的草圖,竟可以被當做逮捕嫌疑人的充分依據。

對此,亞馬遜網路服務首席執行官 Jassy 稱,亞馬遜從未收到對警方誤用技術的投訴。就在今年 5 月,亞馬遜股東投票,否決了一項禁止向警方出售 Rekognition 的提案。亞馬遜的一位代表在一份聲明中說,「亞馬遜從未收到過任何公眾投訴,而且地方機構在使用 Rekognition 方面沒有任何問題。」

立法者&製造商:把「危險的」人臉辨識關進籠子

為了平衡人臉辨識技術的回報與風險,華盛頓州、馬薩諸塞州、奧克蘭市,以及美國立法機構提出了一系列監管建議。眾議院監督和改革委員會的共和黨人和民主黨人舉行了幾個小時的聽證會,並表示兩黨願意共同努力來規範這項技術。

Face API 和 Rekognition 軟體的製造商微軟,和亞馬遜也對聯邦監管表示支持。今年 6 月,美國排名第一的隨身攝影機製造商 Axon 同意其道德委員會的建議,即不要讓 Axon 相機配備臉部辨識裝置。

去年,微軟總裁 Brad Smith 呼籲各國政府「立法來規範這項技術」。而亞馬遜網路服務公司首席執行官 Andy Jassy ,在 6 月份表示附和,他將這項技術比作一把刀。這位來自世界上最強大的臉部辨識技術公司的高管想表達:這個東西很危險。

但在呼籲監管方面,微軟和亞馬遜採取了一個巧妙的伎倆:他們沒有就臉部辨識,是否應該被廣泛應用進行辯論,而是在討論這一技術應該如何被應用。

亞馬遜在《大西洋月刊》上發表的一份聲明中表示,它正在與研究人員、立法者及其客戶合作,「瞭解如何最好地平衡臉部辨識的益處和潛在風險」,並指出 Rekognition 具有多種用途,包括打擊人口販賣並找到失蹤人員。微軟重申 Smith 的聲明,表示支持臉部辨識法規的建立,包括施行針對濫用行為的規範,以及獲得被辨識對象的許可。

但一些隱私專家認為這些公司別有用心。羅切斯特理工學院哲學教授 Evan Selinger 指責微軟和亞馬遜試圖「遏制強有力的監管」。他認為,這些公司努力推動聯邦層面的監管,是因為全國性的法律通常代表著底線,與地方性法律相比,它們不太可能對私營公司如何使用該技術進行限制。

目前看來,學術倫理和技術盲區的問題正在逐步解決,人臉識別的「狂奔」之路並不會因此減速。在人臉識別技術大範圍應用之前,這可能是我們擁有自己面孔的最後時光。

終有一天,我們的臉將不再屬於我們,但在此之前,我們對這項技術的瞭解決定了我們會成為受益者還是受害者。當科技公司不斷地縮小問題的討論範圍,將公共治理轉變為服務條款協議,我們能做的,就是在一方設定條款的時候,不要當不感興趣的另一方,只會簡單地說:「我同意」。

0 comments:

張貼留言